Les JRES, c'est quoi et c'est pour qui ?

Les JRES sont les journées réseaux de l'enseignement supérieur et de la recherche.

Elles sont organisées par RENATER en collaboration avec quelques universités et se déroulent sur quelques jours tous les 2 ans. Cette année, c'est Marseille qui nous a accueilli du 17 au 20 mai 2022.

Les JRES ont pour but de présenter le travail remarquable de certaines équipes sur des sujets intéressant notamment les BIATSS et ITA en charge de l'infrastructure informatique de leur composante.

Elles sont dédiées uniquement à ce type de personnel mais les champs explorés touchant à la recherche et à la pédagogie, il nous a semblé intéressant de vous faire un retour sur certaines présentations auxquelles nous avons assisté et qui pourraient vous concerner en tant qu'enseignant ou chercheur.

Données de recherche

Guide des bonnes pratiques sur la gestion des données de la Recherche

Dans le cadre de l'Open Science, ce guide nous a paru pertinent et bien fait

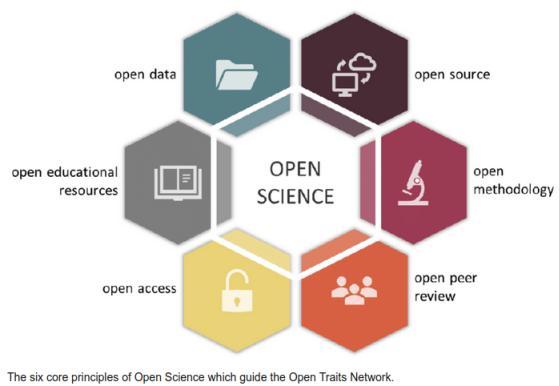

La gestion rigoureuse et cohérente des données de la recherche constitue un enjeu majeur pour la production de nouvelles connaissances scientifiques. Améliorer les pratiques de gestion des données de la science devient nécessaire pour garantir l’intégrité scientifique et la traçabilité de la recherche produite, mais aussi pour rendre accessible, partager, permettre la réutilisation et la reproductibilité des données dans le cadre d'une gestion "FAIR" (findability, accessibility, interoperability, and reusability).

Dans leurs différentes pratiques, les réseaux du CNRS, regroupés au sein de la Mission pour les Initiatives Transverses et Interdisciplinaires (MITI) ou soutenus par les Instituts, participent à ce mouvement d’ouverture et de partage des données. Ce "Guide de bonnes pratiques sur la gestion des données de la recherche" est une production du groupe de travail inter-réseaux "Atelier Données".

L’originalité de ce guide réside dans son application aux données de la recherche sous l’angle de différents métiers. Il fournit un point de vue transversal et traduit les efforts et le soutien des personnels d’appui à la recherche dans la gestion et la valorisation des données scientifiques à travers les nombreux séminaires, communications et formations, qui fournissent l'état de l'art du moment en matière de gestion des données.

Le guide est ici : mi-gt-donnees

Il a été réalisé par le groupe de travail MITI

ERDDAP une plateforme de gestion de données de recherche

Nous avons été très intéressé par cette présentation et pensons qu'il serait pertinent d'avoir cela au LIMOS, n'hésitez pas à tester l'ERDDAP de l'EMSO

Erddap est une plateforme logicielle de distribution de données scientifiques élaborée par la NOAA. Le mantra de cette application est « Easier Access to Scientific Data ». Son but est de faciliter la gestion, l'affichage, et l'accès aux données scientifiques, intégrées au serveur.

L'outil possède de nombreuses fonctionnalités qui en font un outil parfait pour la gestion FAIR des données. C'est un middleware servant de dépôt centralisé, qui gère plusieurs dizaines de formats en entrée/sortie, et qui permet de chercher, interroger, accéder aux données, et générer des graphes.

Erddap est parfait pour centraliser et rendre des données accessibles dans une unité ou dans des projets de gestion de données collaboratifs regroupant les données de plusieurs instituts en réseau

Le ERDDAP de l'EMSO est ici :erddap , n'hésitez pas à le tester et nous donner votre avis.

Cet outil est aussi poussé par la communauté au niveau national car il permet de centraliser les données de recherche en Open Data plus facilement

Impacts environnementaux

Impact des langages de programmation sur la performance énergétique des applications de calcul scientifique

Un benchmark des différents langages sur les performances énergétiques

Le calcul scientifique est de plus en plus utilisé dans la société. Il permet de concevoir, simuler et optimiser de nombreux scénarios pour un coût limité comparativement à la réalisation de prototypes. Il apparaît primordial de se poser la question de l'impact environnemental associé au calcul scientifique.

Lorsque l’on développe un code de calcul scientifique, la première question qui se pose est celle du choix du langage. Il est commun de considérer un certain nombre de critères (lisibilité, pérennité, efficacité, maitrise du langage). Il est bien plus rare de considérer l’efficience énergétique. Cette étude a pour objectif de sensibiliser et inciter à la considération de ce critère.

Un code de démonstration permettant la simulation d’écoulements a ainsi été considéré. Initialement développé en python, ce code a été accéléré (pythran, numba) puis porté dans les langages C, fortran, java, julia, rust, go. Des mesures de performance et de consommation électrique ont été réalisées sur la plate-forme expérimentale Grid’5000, ce qui a permis d’évaluer, dans le contexte très précis du code considéré, l’efficience des langages considérés sur plusieurs architectures.

Le portage rigoureux de code dans un autre langage que celui d’origine, ainsi que l’optimisation de code prend un temps considérable, mais il y a des potentiels de gains énergétiques importants sur la consommation de la phase d’usage du service associé. Ce travail, réalisé dans une approche de science ouverte et reproductible, montre ainsi l’importance des développeurs sur les impacts environnementaux des usages du numérique.

Le PDF est ici : impact_langage_perf_nrj.pdf

Les impacts environnementaux et sociétaux des données

Pour une gestion durable des données, l'approche FAIR

Que ce soit avec le streaming vidéo, le cloud gaming, l'internet des objets (IOT), les réseaux sociaux, l'IA ou les bitcoins, les usages font croître les volumes de données. Dans la recherche, la production et la consommation des données s'envolent également (calculs complexes, modélisation, imagerie spatiale, études environnementales.) Cette accumulation de données se répercute sur les besoins logiciels, matériels et énergétiques qui peinent, malgré les gains d’efficacité, à compenser l'accroissement des usages. Le paradoxe de Jevons reste tristement d'actualité.

Ces usages participent voire amplifient les dérèglements environnementaux (changement climatique, baisse de la biodiversité, épuisement des ressources naturelles, pollutions) tout en soulevant également des questions d'ordre éthique et morale sur la question de qui bénéficie et qui subit.

Les actions permettant de limiter nos impacts sont multiples mais les réponses souvent complexes imposent une réflexion approfondie sur nos usages prenant en compte les aspects sociaux, sociétaux, éco responsable et humains afin d'apporter des réponses pertinentes.

Nous aborderons également la notion d'open data, un des piliers de la science ouverte qui favorise la mutualisation et le partage des données. En effet, le FAIR, même si il peut conduire à un impact numérique accru, reste fondamental afin de respecter le coût environnemental de l’acquisition.

Le PDF est ici : cycle_vie_donnees.pdf

Infrastructure et GPU

Calcul intensif sur GPU : retour d'expérience

Pour voir comment les autres labos travaillent sur GPU

Les thématiques de recherche de l'UMR d’(Epi)génomique Fonctionnelle et Physiologie Moléculaire Du Diabète et Maladies Associées du CNRS, sont caractérisées par la production de très grandes quantités de données de séquençage en un temps limité.

Lors de chaque run, jusqu’à 1.2To de données brutes sont générées sur l’appareil Illumina Novaseq, ce qui représente 30 génomes humains, et ce en 40 heures seulement. L’analyse de ces données génère jusqu’à 10 To supplémentaires, et doit être réalisée dans des délais compatibles avec les impératifs cliniques et le débit de production de données des séquenceurs. La société NVIDIA a récemment développé des versions « GPU accelerated » d'outils phares de la bioinformatique, tel GATK (Genome Analysis Tool Kit) ou BWA (Burrow-Wheeler Aligner). Ces développements visent à répondre à la problématique des temps de calcul nécessaires à l’analyse bioinformatique de données de génétique, qui constitue l’un des grands challenges actuels de la bioinformatique.

Dans ce retour d'expérience, nous présenterons les prérequis matériels, systèmes et réseaux de notre nouvelle infrastructure de calcul (serveur DELL R740, carte GPU Tesla T4, Clara Parabricks). Puis nous présenterons les résultats de l’exploitation de GPUs, en comparaison d'une solution purement CPU, à la fois concernant les temps de calcul et concernant l’identité des résultats générés.

En complément, une comparaison avec une autre solution d’accélération basée sur une carte FPGA spécialement développée pour l’utilisation de ces logiciels (carte Dragen proposée par Illumina) sera également abordée.

Enfin nous terminerons par une solution d’implémentation hybride (multi-CPU/multi-GPU), pour répondre aux besoins d’un pipeline complet d’analyse et d’annotation de variants issus du séquençage d’ADN (méthode WES ou WGS).

Le PDF est ici : calcul_intensif_gpu.pdf

FALL : Mutualisation d'une infrastructure GPU

Nous n'utilisons pas VMWare donc ce projet n'est pas un 'prêt à l'emploi' mais il nous a semblé intéressant de vous faire remonter la technique de mutualisation du GPU

Avec une douzaine de nœuds riches en GPU et rythmés par VMwware Horizon, la plateforme FALL à Grenoble, offre depuis la rentrée 2020 un service de virtualisation d'applications et de postes de travail aux différentes entités de l'établissement.

Une plateforme VDI, ça coûte cher. Le retour sur investissement est complexe à déterminer !

L'usage du VDI étant concentré principalement sur les horaires de bureau, que faire de tous ces temps "morts" de GPU ? Pourquoi pas du calcul ...

Le mésocentre de calcul intensif grenoblois n'en est d'ailleurs pas à sa première expérience de ce genre. Dès les années 2000, le projet "CIMENT" mettait en place sa grille de calcul "CiGri" basée sur le principe de la récupération des cycles inutilisés.

Pour l'utilisateur calcul, FALL est une grappe de calcul dans laquelle les ressources GPU sont volatiles. Bien entendu, cela ne s'adresse qu'à une petite part des utilisateurs, car ce mode de fonctionnement ne convient qu'à certains jobs particuliers.

Alors qu'avons-nous gagné à mutualiser ces ressources GPU ? Comment ça marche techniquement ? Comment tout cela est ressenti côté utilisateurs ? Et du coup, c'est rentable ou pas ?

Le PDF est ici : mutualisation_gpu.pdf

Conclusion

Nous avons vu beaucoup d'autres présentations et vous pourrez retrouver tous les contenus des différentes présentations sur le site des JRES

N'hésitez pas à nous faire des retours sur ce qui vous semble intéressant ou venir en discuter avec nous.